前回は、AIO(AI要約)によって検索が「リンク集」から「結論提示」へ寄り、企業側には“AIに採点される材料”を整える仕事が増える、という話をしました。今回はその延長で、より経営に近い領域——つまり意思決定の中枢にAIが入ってくる変化を扱います。結論から言えば、AIは会議の時間を短くする道具というより、会議の「質」を上げ、意思決定の“学習速度”を上げる仕組みとして捉えた方が良いと思います。

会議の価値は「結論」ではなく「論点抽出」にある

多くの会議は、表向きは結論を出す場ですが、実態は「何を議論すべきか」を決める場でもあります。つまり価値の源泉は、結論そのものよりも、論点の抽出、前提の整理、リスクの洗い出し、反証可能性の確認にあります。ここが曖昧だと、会議は“資料が厚いほど偉い”ゲームになり、論点の抜けや、思い込みの補強が増えます。逆に、論点が良ければ資料は薄くても意思決定は強くなります。

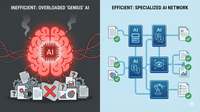

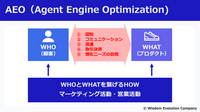

この「論点抽出」を仕組みとして強化するのが、AI人格(複数のAI視点)を使った意思決定支援だと思います。人間は、立場によって見えるリスクが変わります。財務は資金繰り、法務は規制、営業は顧客、現場は運用。経営者は統合判断をしますが、時間は有限で、見落としは必ず起きます。そこにAIを入れて、多様な視点の反対意見を“自動で出す”という発想が現実味を帯びてきました。

事例が示す方向性:「AI役員」「AI参謀」は“人格”で論点を増やす

たとえばキリンの「AI役員 CoreMate」のような取り組みは、その象徴だと思います。過去の議事録や社内資料、外部情報を読み込み、複数の人格(視点)を構築し、会議で議論すべき論点や意見を提示する。ここでの価値は「答えを当てる」ことではなく、「論点の抜け漏れを減らし、意思決定の質とスピードを上げる」ことにあります。

私はこの手のAIを、経営者の“右腕”というより、むしろ「反対意見を制度化する装置」と見ています。組織が大きくなるほど、反対意見は出しにくくなります。空気、政治、時間、関係性。結果として、意思決定は滑らかになる一方で、リスクの発見は遅れます。AI人格は、そこに摩擦を入れてくれます。しかも誰も傷つけない形でです。これは会議文化の改善として非常に大きいと思います。

AI人格の効用は「反証条件」を会議に埋め込めること

意思決定の失敗は、多くの場合「情報不足」ではなく、「反証条件を置いていない」ことから起きます。要するに、外れたときに止まれない。私がAI人格に最も期待するのは、次の問いを必ず出す役割です。

それが正しいなら、どんな兆候が見えるはずですか

それが間違いなら、どんな兆候が先に出ますか

いつ、どの指標で、撤退や縮小を判断しますか

代替案は何で、なぜ捨てたのですか

これらを会議のフォーマットとして固定すると、意思決定は“ギャンブル”から“実験”になります。実験は、当たりでも外れでも学びが残ります。そして学びが残る意思決定は、次の意思決定を速くします。AI人格は、ここを常に促せる点で価値が高いと思います。

落とし穴①:AI人格が「正当化装置」になる危険

一方で、導入には落とし穴もあります。最も危険なのは、AI人格が“反対意見”ではなく“賛成の根拠”として使われることです。人は結論を決めてから理由を集めがちです。AIは文章が上手いので、結論の正当化に使いやすい。すると会議は、反証ではなく補強へ流れます。これを防ぐには、運用上のルールが必要です。

たとえば、AI人格の出力は「賛成と反対を必ずセット」「反対意見の強さを数段階で出す」「反証条件を必ず出す」など、フォーマットを決めます。さらに重要なのは、採用しなかった意見も含めてログを残し、後で検証することです。AIを使ったのに失敗した、ではなく、AIがどんな警告を出し、それをなぜ無視したのかまで残す。ここまでが意思決定支援です。

落とし穴②:責任の所在が曖昧になる

二つ目は責任です。AIが提案し、会議がそれに沿って決めた場合、責任は誰が持つのか。ここを曖昧にすると、組織は弱くなります。私の考えでは、責任は常に人間側に置くべきです。AIは助言者であり、責任者ではありません。だからこそ運用は「AIの提案に従う」ではなく、「AIの提案を議論の素材として使う」に止める必要があります。

この点は言い換えると、AI人格は“意思決定の代行”ではなく、“意思決定の質を上げる補助輪”だということです。補助輪があるから無茶ができるのではなく、転びにくくなる。その程度の位置づけが健全だと思います。

落とし穴③:情報ガバナンスと機密の扱い

三つ目は情報です。議事録や社内資料を入れる以上、情報ガバナンスは避けて通れません。誰がアクセスできるのか、どの範囲のログを学習に使うのか、外部情報の扱いはどうするのか。特に、会議で扱う未公開情報や人事情報、取引先情報はセンシティブです。ここを曖昧にしたまま導入すると、現場は怖くて使えません。結果として使われないか、あるいは一部の人だけが勝手に使って“闇ツール化”します。

したがって、先に決めるべきは技術より運用です。権限設計、保存期間、削除ルール、監査、そして「入れてはいけない情報」のルール。AIを使うほど、ルール整備が価値になる時代です。

実務チェック:AI人格を会議に入れるときの最小セット

では、実務として何を揃えるべきでしょうか。私は最小セットとして、次の流れを勧めます。

入力テンプレ:議題の型を揃える

目的(何を決める会議か)

前提(変えない条件)

選択肢(最低2案)

リスク(既知のもの)

期限(いつまでに決めるか)

出力テンプレ:AI人格の出力フォーマットを固定する

・論点一覧(漏れの指摘)・賛成理由/反対理由

・反証条件(撤退条件)

・必要な追加情報(調査項目)

・議論順序(優先順位)

採用・不採用ログ:意思決定ログを残す

採用した論点/捨てた論点

捨てた理由

次回見直し時期

測る指標(KPI)

担当(オーナー)

この3点が揃うと、AI人格は「会議を賢く見せる演出」ではなく、「意思決定を学習に変える装置」になります。

AI人格の本質は“会議を短くする”ではなく“会議を強くする”

ここで誤解されやすいのですが、AI人格を入れたから会議がすぐ半分になる、という話ではないと思います。むしろ最初は、論点が増えて会議が長く感じるかもしれません。しかしそれは健全な痛みです。なぜなら今まで見えていなかった論点が見えるようになったからです。

そして数ヶ月後、意思決定ログが溜まってくると、会議は“同じ議論の繰り返し”が減り、早くなります。過去の判断と結果が参照できるからです。つまり短縮は結果であって目的ではありません。目的は意思決定の質と学習速度です。

次回予告:会議の外にある知恵を、資産に変える

AI人格が会議を強くする一方で、組織の知恵の多くは会議の外にあります。雑談、現場の小さな気づき、顧客対応のメモ、口頭の意思決定。これらは記録されずに消え、毎回同じ議論が生まれます。次回は、そうした“消える知恵”をログとして蓄積し、検索できる資産へ変える「全社ログ革命」を扱います。AI活用の本丸は、生成ではなく、学習資産の蓄積にある——その具体像を整理します。

まとめると、AI人格は答えを当てる道具ではなく、反証条件と多様な論点を会議に埋め込み、意思決定を学習に変える仕組みだと思います。

まだ会員登録されていない方へ

会員になると、既読やブックマーク(また読みたい記事)の管理ができます。今後、会員限定記事も予定しています。登録は無料です